Merhaba dostlar ben DSOWWW. Forumda nedirden ziyade nasıl yapılır tarzı konular açmaya gayret ediyorum. Bugünkü konumuzda hedef sistem hakkında bilgi toplama aşamalarından biri olan "Enumeration" hakkında konuşacağız ve uygulamalı olarak çeşitli araçlarla bilgi toplayacağız. Tavsiyem kesinlikle terminalinizi açıp benimle beraber denemeniz, sorunuz olursa sormaktan çekinmeyin. Hemen başlayalım.

Enumeration Nedir?

Kısaca "Enumeration" saldırganların hedefle ilgili daha fazla bilgi elde etmeye yönelik sorgular yapıp sisteme giden aktif bağlantılar oluşturması işlemine denilmektedir.

Neden Enumeration?

Hepinizin bildiği gibi sistemleri hacklemek için önce o sistem hakkında bilgi toplamamız gerekmekte. Ben de şimdi size tam olarak bunu anlatacağım.

Websiteler Hakkında Bilgi Toplamak İçin Kullanacağımız Araçlar ve Kullanım Şekilleri:

1-Dirb

DIRB bir Web içerik tarayıcısıdır.Yani hedef aldığınız siteyi tarayarak bütün içerikleri, linkleri vb. çıkarıp size listeleyen bir araçtır.

Sitelerde arka planda ön tarafa yansımayan, yansıması istenmeyen bir çok içerik vardır. Veya yazılımcıların kıyıda köşede unuttuğu veya yanlış yapılandırdığı yerler olabilir. İşte bu tip bize görünen veya görünmeyen, gizlenen bütün içerikleri tarayıp listelemek isterseniz Dirb aracımızı kullanmamız gerekmekte.

Dirb ile Alt Dizinleri Tarayalım!

Evet şimdi gelin beraber alt dizin taraması yapalım, öncelikle toolu yükleyeceğiz. Bu komutla toolu yükleyebilirsiniz:

Toolumuzu dirb yazarak başlatalım.

Görünüşe göre tonlarca parametre var! Tabii ben sizi bu durumdan kurtarıp en basit bir şekilde nasıl kullanabileceğimizi göstereceğim.

Basit bir şeklide sadece alt dizin taramasını şu şekil yapabiliriz:

Eğer dizin taraması için wordlist değiştirmek isterseniz de yanına parametre belirtmeden wordlistin konumunu yazmanız yetiyor.

2-Uniscan

Uniscan bir zaafiyet tarama aracıdır arkadaşlar. Sql, xss, vb. birçok açığı bulmanıza yardımcı olan önemli bir araçtır.

Uniscan'i terminalinize;

yazarak veya kendi adresinden klonlayabilirsiniz.

Uniscan ile Sitemizi Tarayalım!

Öncelikle parametrelerimizi tanıyalım:

-q : Dizin Parametresi. Açık bulunan dizinleri listeleyecektir.

-w : Dosya parametresi. Bulabildiği dosyaları listeleyecektir.

-e : Taranacak site üzerinde bulunan robots.txt dosyasını ve sitemap.xml dosyasını gösterecektir.

-d : Dinamik dediğimiz diğerlerine göre daha hızlı biten bir tarama gerçekleştirecektir. (Xss,Rfi, Backup Files)

-s : Statik dediğimiz daha uzun süren ve daha geniş bir rapor sunan tarama gerçekleştirir. (Sql, Xss vs.)

-r : Sitenin php bilgilerini taramak için kullanılan yoldur

-u : hedef siteyi belirtmek için en başta yazmamız gereken parametredir.

Parametreleri öğrendikten sonra taramamızı yapalım:

Burada toolun çalışma gereği parametreleri " -qweds " şeklinde yazdım. Siz de dikkat ederek yazın.

3-Nikto

Nikto, güvenlik taraması yapan web Zaafiyet aracıdır. Biz Nikto'yu genel bir tarama yapmak için kullanacağız. Terminalinize

"apt-get install nikto"

yazarak indirebilirsiniz. Kullanımına geçelim işte -T ile belirtmemiz gereken nikto parametreleri:

1 ilginç Dosyalar / Seen in logs

2 Yanlış Yapılandırma / Varsayılan Dosya

3 Bilginin Açıklanması

4 Enjeksiyon (XSS / Script / HTML)

5 Uzaktan Dosya Alma – İç Web Kökü

6 Hizmet Reddi

7 Uzaktan Dosya Alma – Sunucu Genişliği

8 Komut Yürütme / Uzak Kabuk

9 SQL Enjeksiyonu

0 Dosya Yükleme

a Kimlik Doğrulama Bypass

b Yazılım Kimliği

c Uzak Kaynak İçerme

d Web Service

e İdari Konsol

x Ters Ayarlama Seçenekleri (diğer bir deyişle belirtilen dışında hepsini içerir)

Bu da basit bir kullanımı:

Peki ya daha geniş kullanmak istersek? O zaman görseldeki gibi kullanacağız:

Görüldüğü üzere nikto tüm bulabileceği zaafiyetleri taramaya çalışıyor. Siz de deneyerek zaafiyetleri araştırabilirsiniz.

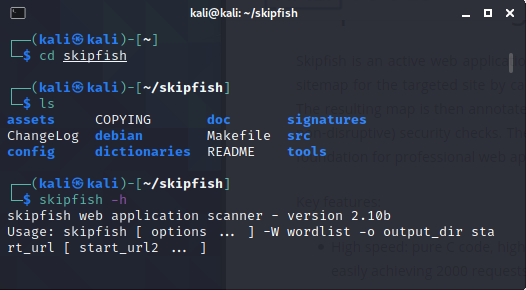

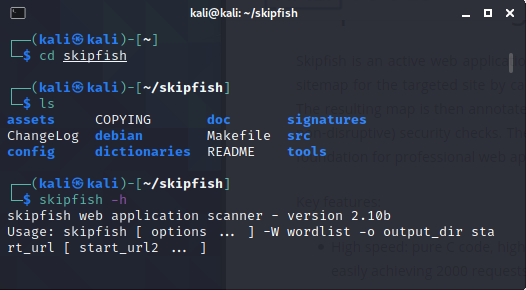

4-Skipfish

4-Skipfish

Skipfish'de aynı gösterdiğim toollar gibi genel zaafiyetleri tarıyor ancak diğerlerinden farkını sorarsanız C dili ile yazıldığı için yüksek hızlı, HTTP trafiklerini saniyede 2000 requeste kadar kaldırabilen harika bir tooldur. Ayrıca kullanımı basittir.

Peki tool bize ne sunar:

Yüksek riskli kusurlar (potansiyel olarak sistemin tehlikeye girmesine yol açar):

Sunucu tarafı SQL / PHP enjeksiyonu (kör vektörler, sayısal parametreler dahil).

GET veya POST parametrelerinde açık SQL benzeri sözdizimi.

Sunucu tarafı kabuk komut enjeksiyonu (kör vektörler dahil).

Sunucu tarafı XML / XPath enjeksiyonu (kör vektörler dahil).

Dize güvenlik açıklarını biçimlendirin.

Tamsayı taşması güvenlik açıkları.

HTTP PUT'u kabul eden konumlar.

Orta riskli kusurlar (potansiyel olarak veri güvenliğinin ihlal edilmesine yol açar):

Belge gövdesinde saklanan ve yansıtılan XSS vektörleri (minimum JS XSS desteği mevcuttur).

HTTP yönlendirmeleri aracılığıyla depolanan ve yansıtılan XSS vektörleri.

HTTP başlık bölme yoluyla depolanan ve yansıtılan XSS vektörleri.

Dizin geçişi / dosya dahil etme (kısıtlanmış vektörler dahil).

Çeşitli dosya POI'leri (sunucu tarafı kaynakları, yapılandırmalar, vb.).

Saldırgan tarafından sağlanan komut dosyası ve CSS dahil etme vektörleri (depolanır ve yansıtılır).

Harici güvenilmeyen komut dosyası ve CSS dahil etme vektörleri.

Komut dosyası ve CSS kaynaklarında karışık içerik sorunları (isteğe bağlı).

SSL olmayan sayfalardan veya bu sayfalara gönderilen şifre formları (isteğe bağlı).

Oluşturulabilir öğelerde yanlış veya eksik MIME türleri.

Renderable'larda genel MIME türleri.

Oluşturulabilir öğelerde yanlış veya eksik karakter kümeleri.

Oluşturulabilir öğelerde çelişkili MIME / karakter kümesi bilgisi.

Tanımlama bilgisi ayarı yanıtlarında hatalı önbelleğe alma yönergeleri.

Düşük riskli sorunlar (sınırlı etki veya düşük özgüllük):

Bypass vektörlerini listeleyen dizin.

Saldırgan tarafından sağlanan URL'lere yönlendirme (depolanır ve yansıtılır).

Saldırgan tarafından sağlanan katıştırılmış içerik (depolanır ve yansıtılır).

Dış güvenilmeyen katıştırılmış içerik.

Komut dosyası oluşturulamayan alt kaynaklarda karışık içerik (isteğe bağlı).

HTTPS -> HTML formlarının HTTP gönderimi (isteğe bağlı).

URL'lerde HTTP kimlik bilgileri.

Süresi dolmuş veya henüz geçerli olmayan SSL sertifikaları.

XSRF koruması olmayan HTML formları.

Kendinden imzalı SSL sertifikaları.

SSL sertifikası ana bilgisayar adı uyuşmazlıkları.

Daha az hassas içerikte hatalı önbelleğe alma yönergeleri.

Dahili uyarılar:

Başarısız kaynak getirme girişimleri.

Tarama sınırları aşıldı.

Başarısız 404 davranış kontrolü.

IPS filtreleme algılandı.

Beklenmeyen yanıt varyasyonları.

Görünüşe göre yanlış sınıflandırılmış tarama düğümleri.

Spesifik olmayan bilgi girişleri:

Genel SSL sertifikası bilgileri.

Önemli ölçüde değişen HTTP tanımlama bilgileri.

Server, Via, veya X-...başlıkları değiştirme .

Yeni 404 imza.

Erişilemeyen kaynaklar.

HTTP kimlik doğrulaması gerektiren kaynaklar.

Bozuk bağlantılar.

Sunucu hataları.

Aksi şekilde sınıflandırılmayan tüm harici bağlantılar (isteğe bağlı).

Tüm harici e-postalar (isteğe bağlı).

Tüm harici URL yönlendiricileri (isteğe bağlı).

Bilinmeyen protokollere bağlantılar.

Otomatik olarak doldurulamayan form alanları.

Parola giriş formları (harici kaba kuvvet için).

Dosya yükleme formları.

Diğer HTML formları (başka türlü sınıflandırılmamıştır).

Sayısal dosya adları (harici kaba kuvvet için).

Kullanıcı tarafından sağlanan bağlantılar, aksi takdirde bir sayfada işlenir.

Daha az önemli içerikte yanlış veya eksik MIME türü.

Daha az önemli içerikte genel MIME türü.

Daha az önemli içerikte yanlış veya eksik karakter kümesi.

Daha az önemli içerikle ilgili çelişkili MIME / karakter kümesi bilgileri.

OGNL benzeri parametre geçiş kuralları.

Ohoo... Kullanıma geçelim dediğinizi duyar gibiyim. Hadi geçelim!

Toolu "apt-get install -y skipfish" yazarak indirebiliriz. Kullanımını inceleyelim.

Skipfish ile wordpress sitesi tarayalım:

Kullanımımız şu şekildir:

" skipfish -o 202 http://192.168.1.202/wordpress "

Bunu yaptıktan sonra taramamız başlıyor. 5-10 dk civarı sürebiliyor çünkü geniş bir aralıkta tarama yapıyoruz. Bu toolun kullanımı kolaydır fakat tüm kullanım şekillerine değinemeyeceğim siz buradan bakabilirsiniz

Bu günlük benden bu kadar arkadaşlar okuduğunuz için teşekkürler, umarım size faydası dokunur. Çok zamanımı aldı konuyu açmak. Sizden ricam beğenip konuya destek olamanız. Ayrıca kulübümüzde düzenli olarak etkinlikler düzenliyoruz. Siz de buradan katılabilirsiniz. Gereken desteği verirseniz daha çok konu açmaya gayret edeceğim. İlginizi çektiyse şu konulara da bakabilirsiniz:

www.turkhackteam.org

www.turkhackteam.org

Neden Enumeration?

Hepinizin bildiği gibi sistemleri hacklemek için önce o sistem hakkında bilgi toplamamız gerekmekte. Ben de şimdi size tam olarak bunu anlatacağım.

Websiteler Hakkında Bilgi Toplamak İçin Kullanacağımız Araçlar ve Kullanım Şekilleri:

1-Dirb

DIRB bir Web içerik tarayıcısıdır.Yani hedef aldığınız siteyi tarayarak bütün içerikleri, linkleri vb. çıkarıp size listeleyen bir araçtır.

Sitelerde arka planda ön tarafa yansımayan, yansıması istenmeyen bir çok içerik vardır. Veya yazılımcıların kıyıda köşede unuttuğu veya yanlış yapılandırdığı yerler olabilir. İşte bu tip bize görünen veya görünmeyen, gizlenen bütün içerikleri tarayıp listelemek isterseniz Dirb aracımızı kullanmamız gerekmekte.

Dirb ile Alt Dizinleri Tarayalım!

Evet şimdi gelin beraber alt dizin taraması yapalım, öncelikle toolu yükleyeceğiz. Bu komutla toolu yükleyebilirsiniz:

apt-get install dirbToolumuzu dirb yazarak başlatalım.

Görünüşe göre tonlarca parametre var! Tabii ben sizi bu durumdan kurtarıp en basit bir şekilde nasıl kullanabileceğimizi göstereceğim.

Basit bir şeklide sadece alt dizin taramasını şu şekil yapabiliriz:

Eğer dizin taraması için wordlist değiştirmek isterseniz de yanına parametre belirtmeden wordlistin konumunu yazmanız yetiyor.

2-Uniscan

Uniscan bir zaafiyet tarama aracıdır arkadaşlar. Sql, xss, vb. birçok açığı bulmanıza yardımcı olan önemli bir araçtır.

Uniscan'i terminalinize;

apt-get install uniscanyazarak veya kendi adresinden klonlayabilirsiniz.

Uniscan ile Sitemizi Tarayalım!

Öncelikle parametrelerimizi tanıyalım:

-q : Dizin Parametresi. Açık bulunan dizinleri listeleyecektir.

-w : Dosya parametresi. Bulabildiği dosyaları listeleyecektir.

-e : Taranacak site üzerinde bulunan robots.txt dosyasını ve sitemap.xml dosyasını gösterecektir.

-d : Dinamik dediğimiz diğerlerine göre daha hızlı biten bir tarama gerçekleştirecektir. (Xss,Rfi, Backup Files)

-s : Statik dediğimiz daha uzun süren ve daha geniş bir rapor sunan tarama gerçekleştirir. (Sql, Xss vs.)

-r : Sitenin php bilgilerini taramak için kullanılan yoldur

-u : hedef siteyi belirtmek için en başta yazmamız gereken parametredir.

Parametreleri öğrendikten sonra taramamızı yapalım:

Burada toolun çalışma gereği parametreleri " -qweds " şeklinde yazdım. Siz de dikkat ederek yazın.

3-Nikto

Nikto, güvenlik taraması yapan web Zaafiyet aracıdır. Biz Nikto'yu genel bir tarama yapmak için kullanacağız. Terminalinize

"apt-get install nikto"

yazarak indirebilirsiniz. Kullanımına geçelim işte -T ile belirtmemiz gereken nikto parametreleri:

1 ilginç Dosyalar / Seen in logs

2 Yanlış Yapılandırma / Varsayılan Dosya

3 Bilginin Açıklanması

4 Enjeksiyon (XSS / Script / HTML)

5 Uzaktan Dosya Alma – İç Web Kökü

6 Hizmet Reddi

7 Uzaktan Dosya Alma – Sunucu Genişliği

8 Komut Yürütme / Uzak Kabuk

9 SQL Enjeksiyonu

0 Dosya Yükleme

a Kimlik Doğrulama Bypass

b Yazılım Kimliği

c Uzak Kaynak İçerme

d Web Service

e İdari Konsol

x Ters Ayarlama Seçenekleri (diğer bir deyişle belirtilen dışında hepsini içerir)

Bu da basit bir kullanımı:

nikto -h hedefsite.comPeki ya daha geniş kullanmak istersek? O zaman görseldeki gibi kullanacağız:

Görüldüğü üzere nikto tüm bulabileceği zaafiyetleri taramaya çalışıyor. Siz de deneyerek zaafiyetleri araştırabilirsiniz.

Skipfish'de aynı gösterdiğim toollar gibi genel zaafiyetleri tarıyor ancak diğerlerinden farkını sorarsanız C dili ile yazıldığı için yüksek hızlı, HTTP trafiklerini saniyede 2000 requeste kadar kaldırabilen harika bir tooldur. Ayrıca kullanımı basittir.

Peki tool bize ne sunar:

Yüksek riskli kusurlar (potansiyel olarak sistemin tehlikeye girmesine yol açar):

Sunucu tarafı SQL / PHP enjeksiyonu (kör vektörler, sayısal parametreler dahil).

GET veya POST parametrelerinde açık SQL benzeri sözdizimi.

Sunucu tarafı kabuk komut enjeksiyonu (kör vektörler dahil).

Sunucu tarafı XML / XPath enjeksiyonu (kör vektörler dahil).

Dize güvenlik açıklarını biçimlendirin.

Tamsayı taşması güvenlik açıkları.

HTTP PUT'u kabul eden konumlar.

Orta riskli kusurlar (potansiyel olarak veri güvenliğinin ihlal edilmesine yol açar):

Belge gövdesinde saklanan ve yansıtılan XSS vektörleri (minimum JS XSS desteği mevcuttur).

HTTP yönlendirmeleri aracılığıyla depolanan ve yansıtılan XSS vektörleri.

HTTP başlık bölme yoluyla depolanan ve yansıtılan XSS vektörleri.

Dizin geçişi / dosya dahil etme (kısıtlanmış vektörler dahil).

Çeşitli dosya POI'leri (sunucu tarafı kaynakları, yapılandırmalar, vb.).

Saldırgan tarafından sağlanan komut dosyası ve CSS dahil etme vektörleri (depolanır ve yansıtılır).

Harici güvenilmeyen komut dosyası ve CSS dahil etme vektörleri.

Komut dosyası ve CSS kaynaklarında karışık içerik sorunları (isteğe bağlı).

SSL olmayan sayfalardan veya bu sayfalara gönderilen şifre formları (isteğe bağlı).

Oluşturulabilir öğelerde yanlış veya eksik MIME türleri.

Renderable'larda genel MIME türleri.

Oluşturulabilir öğelerde yanlış veya eksik karakter kümeleri.

Oluşturulabilir öğelerde çelişkili MIME / karakter kümesi bilgisi.

Tanımlama bilgisi ayarı yanıtlarında hatalı önbelleğe alma yönergeleri.

Düşük riskli sorunlar (sınırlı etki veya düşük özgüllük):

Bypass vektörlerini listeleyen dizin.

Saldırgan tarafından sağlanan URL'lere yönlendirme (depolanır ve yansıtılır).

Saldırgan tarafından sağlanan katıştırılmış içerik (depolanır ve yansıtılır).

Dış güvenilmeyen katıştırılmış içerik.

Komut dosyası oluşturulamayan alt kaynaklarda karışık içerik (isteğe bağlı).

HTTPS -> HTML formlarının HTTP gönderimi (isteğe bağlı).

URL'lerde HTTP kimlik bilgileri.

Süresi dolmuş veya henüz geçerli olmayan SSL sertifikaları.

XSRF koruması olmayan HTML formları.

Kendinden imzalı SSL sertifikaları.

SSL sertifikası ana bilgisayar adı uyuşmazlıkları.

Daha az hassas içerikte hatalı önbelleğe alma yönergeleri.

Dahili uyarılar:

Başarısız kaynak getirme girişimleri.

Tarama sınırları aşıldı.

Başarısız 404 davranış kontrolü.

IPS filtreleme algılandı.

Beklenmeyen yanıt varyasyonları.

Görünüşe göre yanlış sınıflandırılmış tarama düğümleri.

Spesifik olmayan bilgi girişleri:

Genel SSL sertifikası bilgileri.

Önemli ölçüde değişen HTTP tanımlama bilgileri.

Server, Via, veya X-...başlıkları değiştirme .

Yeni 404 imza.

Erişilemeyen kaynaklar.

HTTP kimlik doğrulaması gerektiren kaynaklar.

Bozuk bağlantılar.

Sunucu hataları.

Aksi şekilde sınıflandırılmayan tüm harici bağlantılar (isteğe bağlı).

Tüm harici e-postalar (isteğe bağlı).

Tüm harici URL yönlendiricileri (isteğe bağlı).

Bilinmeyen protokollere bağlantılar.

Otomatik olarak doldurulamayan form alanları.

Parola giriş formları (harici kaba kuvvet için).

Dosya yükleme formları.

Diğer HTML formları (başka türlü sınıflandırılmamıştır).

Sayısal dosya adları (harici kaba kuvvet için).

Kullanıcı tarafından sağlanan bağlantılar, aksi takdirde bir sayfada işlenir.

Daha az önemli içerikte yanlış veya eksik MIME türü.

Daha az önemli içerikte genel MIME türü.

Daha az önemli içerikte yanlış veya eksik karakter kümesi.

Daha az önemli içerikle ilgili çelişkili MIME / karakter kümesi bilgileri.

OGNL benzeri parametre geçiş kuralları.

Ohoo... Kullanıma geçelim dediğinizi duyar gibiyim. Hadi geçelim!

Toolu "apt-get install -y skipfish" yazarak indirebiliriz. Kullanımını inceleyelim.

Skipfish ile wordpress sitesi tarayalım:

Kullanımımız şu şekildir:

" skipfish -o 202 http://192.168.1.202/wordpress "

Bunu yaptıktan sonra taramamız başlıyor. 5-10 dk civarı sürebiliyor çünkü geniş bir aralıkta tarama yapıyoruz. Bu toolun kullanımı kolaydır fakat tüm kullanım şekillerine değinemeyeceğim siz buradan bakabilirsiniz

Bu günlük benden bu kadar arkadaşlar okuduğunuz için teşekkürler, umarım size faydası dokunur. Çok zamanımı aldı konuyu açmak. Sizden ricam beğenip konuya destek olamanız. Ayrıca kulübümüzde düzenli olarak etkinlikler düzenliyoruz. Siz de buradan katılabilirsiniz. Gereken desteği verirseniz daha çok konu açmaya gayret edeceğim. İlginizi çektiyse şu konulara da bakabilirsiniz:

Python ile En Son Olan 10 Depremi Öğrenelim

Merhaba bugün sizlerle basit bir proje paylaşmak istedim, koltukta uzanırken bunu yapmak aklıma geldi bende dedim ki neden olmasın? Her neyse klasik python abiyi kullanacağız başlayalım kod parçaları gayet basit ve anlaşılır . Projede requests ve BeautifulSoup kütüphanelerini kullandım. Requests...